Google Search Consoleデータの可視化とクラスタリング分析とは何か?その概要と重要性について

目次

Google Search Consoleデータの可視化とクラスタリング分析とは何か?その概要と重要性について

Google Search Consoleデータの可視化とクラスタリング分析は、ウェブサイトのパフォーマンスを理解し、最適化するための強力な手法です。Google Search Consoleは、ウェブサイトの検索エンジンパフォーマンスに関する豊富なデータを提供しますが、そのままでは全体像を把握するのは困難です。そこで、データを可視化し、クラスタリング分析を行うことで、特定のパターンやトレンドを明確にし、効果的なSEO戦略を策定することが可能になります。

Google Search Consoleデータの役割と利用価値

Google Search Consoleは、ウェブサイトがどのように検索エンジンとインタラクションしているかを示すデータを提供します。これには、インプレッション数、クリック数、平均掲載順位、検索クエリなどが含まれます。これらのデータを分析することで、ユーザーの検索行動やウェブサイトのパフォーマンスを深く理解することができます。

クラスタリング分析の基本概念と利点

クラスタリング分析は、データを類似性に基づいてグループに分類する手法です。これにより、似た特性を持つデータポイントをグループ化し、特定のパターンやトレンドを明らかにします。例えば、検索クエリをクラスタリングすることで、ユーザーの関心や行動を理解しやすくなります。

データ可視化の重要性とその効果

データ可視化は、複雑なデータを視覚的に理解しやすい形式で表示する方法です。これにより、データの傾向やパターンを迅速に把握し、意思決定を支援します。視覚的なデータ表現は、ステークホルダーとのコミュニケーションにも役立ちます。

実際の業務での適用例と成功事例

Google Search Consoleデータの可視化とクラスタリング分析は、多くの企業で実際に利用され、成功を収めています。例えば、特定のクエリグループに焦点を当てたコンテンツ改善により、クリック率やコンバージョン率が向上したケースなどがあります。

この分析手法の全体的なプロセス概要

この手法の全体的なプロセスは、データの収集、前処理、エンベディング、クラスタリング、そして可視化と続きます。Pythonや他のプログラミング言語を用いてこれらのステップを自動化することで、効率的かつ効果的にデータ分析を行うことができます。

クラスタリング結果の分析方法とその活用法

クラスタリング結果の分析は、ウェブサイトの改善点を特定し、具体的なアクションプランを策定するための重要なステップです。各クラスタの特徴を把握し、どのクエリやページがどのクラスタに属するかを理解することで、ターゲットを絞った改善が可能になります。

クラスタリング結果の評価指標と分析方法

クラスタリング結果を評価するための指標として、シルエットスコアやダビーズボルディン指数などが利用されます。これらの指標を用いてクラスタの質を評価し、最適なクラスタ数を決定します。

クラスタごとの特徴とトレンドの把握

各クラスタの特徴を分析することで、ユーザーの検索意図や行動を把握できます。例えば、特定のクラスタが特定の製品カテゴリに関連している場合、そのカテゴリに焦点を当てたマーケティング戦略を策定することが可能です。

クラスタリング結果を利用したSEO戦略の策定

クラスタリング結果に基づいて、特定のキーワードグループやコンテンツグループに対するSEO戦略を策定します。これにより、効率的なリソース配分とターゲティングが可能になります。

実際のデータを用いたケーススタディ

実際のデータを用いたケーススタディでは、具体的なクラスタリング分析の実施方法と、その結果をどのように活用したかを解説します。これにより、読者は実践的な知識を得ることができます。

分析結果のレポート作成と共有方法

分析結果をレポートとしてまとめることで、関係者に分かりやすく伝えることができます。視覚的なグラフやチャートを用いて、結果の要点を明確にし、次のステップへの道筋を示します。

# クラスタリングのサンプルコード

import pandas as pd

from sklearn.cluster import KMeans

import matplotlib.pyplot as plt

# データの読み込み

data = pd.read_csv('search_console_data.csv')

# 特徴量の選択

features = data[['impressions', 'clicks', 'position']]

# クラスタリングの実行

kmeans = KMeans(n_clusters=5, random_state=0).fit(features)

# クラスタリング結果の追加

data['cluster'] = kmeans.labels_

# クラスタごとの特性を可視化

plt.scatter(data['impressions'], data['clicks'], c=data['cluster'], cmap='viridis')

plt.xlabel('Impressions')

plt.ylabel('Clicks')

plt.title('Clustering of Search Console Data')

plt.show()

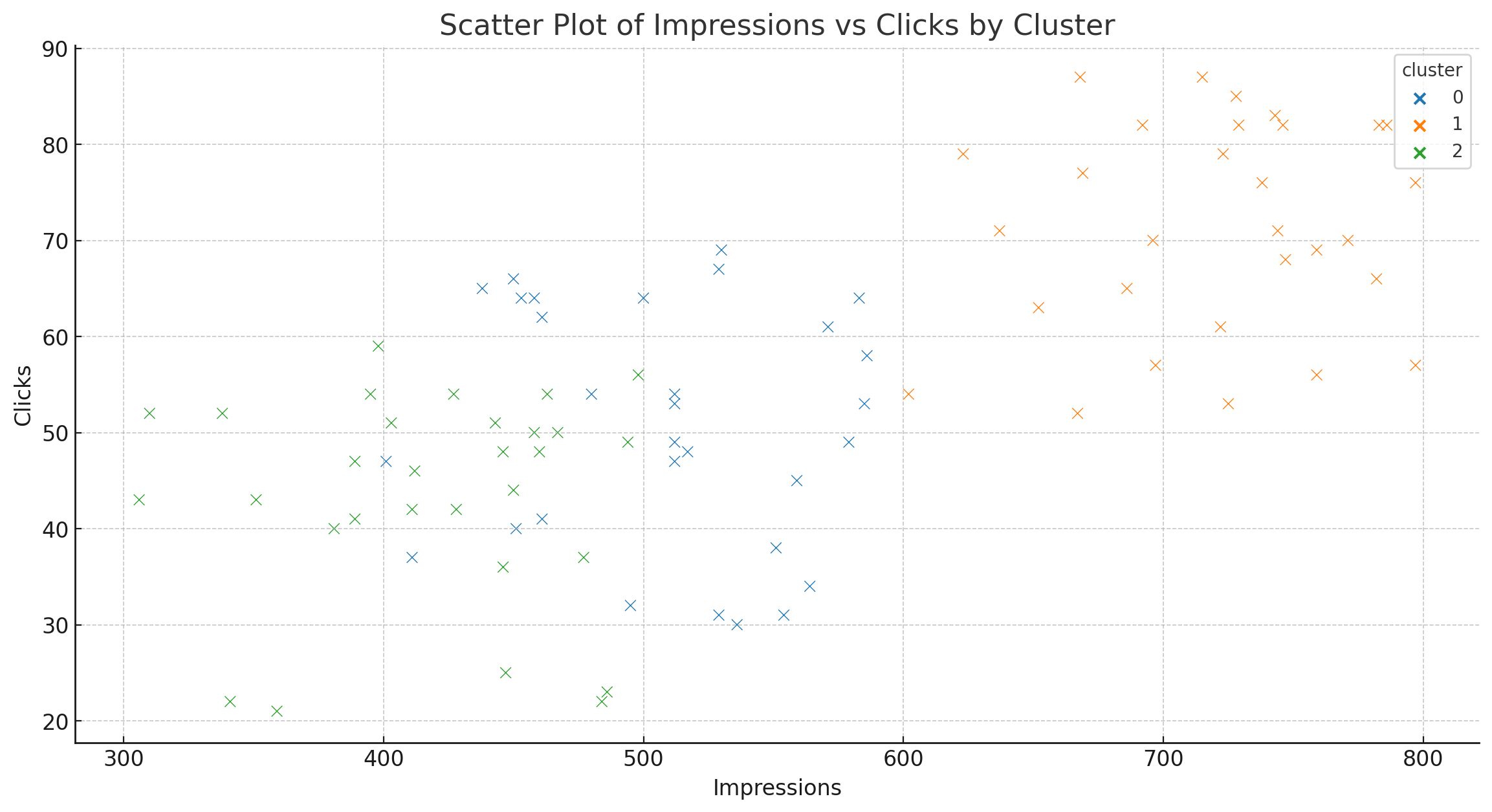

各クラスタの毎日のインプレッション数とクリック数の詳細分析

インプレッション数とクリック数は、ウェブサイトのパフォーマンスを評価するための重要な指標です。インプレッション数は、検索結果ページでウェブサイトのリンクが表示された回数を示し、クリック数はそのリンクがクリックされた回数を示します。これらの指標をクラスタごとに分析することで、各クラスタのパフォーマンスの違いを明らかにし、改善のための具体的な施策を講じることができます。

インプレッション数とクリック数の基本概念と違い

インプレッション数は、検索結果ページに表示された回数であり、クリック数は実際にクリックされた回数です。インプレッション数が多いがクリック数が少ない場合、そのページのメタデータやタイトルがユーザーの関心を引いていない可能性があります。逆に、クリック数が多い場合、そのページの内容がユーザーにとって魅力的であることを示しています。

クラスタごとのインプレッション数の変動パターン

クラスタごとのインプレッション数の変動パターンを分析することで、特定の時期やイベントがインプレッション数にどのような影響を与えているかを理解できます。例えば、特定のクラスタが特定のキャンペーン期間中に急増する場合、そのキャンペーンが成功したことを示しています。

クリック数の増減要因とその対策

クリック数の増減要因を特定し、それに基づく対策を講じることが重要です。例えば、ページの内容やメタデータの最適化、リンクの配置やデザインの改善などが考えられます。これにより、ユーザーエンゲージメントを向上させ、ウェブサイトのパフォーマンスを改善することが可能です。

データの可視化による傾向の把握

データの可視化は、インプレッション数やクリック数の傾向を迅速に把握するための有効な手段です。グラフやチャートを用いることで、各クラスタのパフォーマンスを視覚的に理解しやすくなります。以下は、Pythonを用いたデータ可視化のサンプルコードです。

# データ可視化のサンプルコード

import matplotlib.pyplot as plt

import seaborn as sns

# データの読み込み

data = pd.read_csv('search_console_data.csv')

# クラスタごとの日別インプレッション数とクリック数の集計

daily_data = data.groupby(['date', 'cluster']).sum().reset_index()

# インプレッション数の可視化

plt.figure(figsize=(14, 7))

sns.lineplot(data=daily_data, x='date', y='impressions', hue='cluster', palette='tab10')

plt.title('Daily Impressions by Cluster')

plt.xlabel('Date')

plt.ylabel('Impressions')

plt.show()

# クリック数の可視化

plt.figure(figsize=(14, 7))

sns.lineplot(data=daily_data, x='date', y='clicks', hue='cluster', palette='tab10')

plt.title('Daily Clicks by Cluster')

plt.xlabel('Date')

plt.ylabel('Clicks')

plt.show()

具体的な改善施策の提案と実行方法

具体的な改善施策としては、以下のようなものが考えられます:

1. メタデータの最適化: ページタイトルや説明文をユーザーが興味を持つ内容に変更する。

2. コンテンツの改善: ユーザーのニーズに合った高品質なコンテンツを提供する。

3. 内部リンクの最適化: ユーザーが関連情報に簡単にアクセスできるようにする。

4. モバイルフレンドリーなデザイン: モバイルユーザー向けにページを最適化する。

これらの施策を実行することで、インプレッション数やクリック数の向上が期待できます。

Google Search Consoleデータの抽出方法と具体的な手順

Google Search Consoleデータの抽出は、ウェブサイトのパフォーマンスを詳細に分析するための第一歩です。APIを利用することで、自動化されたデータ抽出が可能になり、定期的な分析が容易になります。以下では、Google Search Console APIの利用方法とPythonを用いたデータ抽出の具体的な手順を紹介します。

Google Search Console APIの利用方法

Google Search Console APIを利用することで、手動でデータをダウンロードする手間を省くことができます。APIを使用するには、まずGoogle Cloud Consoleでプロジェクトを作成し、APIキーを取得する必要があります。

Pythonを用いたデータ抽出のサンプルコード

Pythonを使用してGoogle Search Consoleデータを抽出する方法は非常に便利です。以下は、Pythonを用いたデータ抽出のサンプルコードです。

# Google Search Console APIを利用したデータ抽出のサンプルコード

from googleapiclient.discovery import build

from oauth2client.service_account import ServiceAccountCredentials

import pandas as pd

# 認証情報の設定

SCOPES = ['https://www.googleapis.com/auth/webmasters.readonly']

KEY_FILE_LOCATION = 'path/to/your/service-account-key.json'

SITE_URL = 'https://www.yoursite.com'

# 認証のセットアップ

credentials = ServiceAccountCredentials.from_json_keyfile_name(KEY_FILE_LOCATION, SCOPES)

webmasters_service = build('webmasters', 'v3', credentials=credentials)

# クエリの作成

request = {

'startDate': '2023-01-01',

'endDate': '2023-01-31',

'dimensions': ['query'],

'rowLimit': 1000

}

# データの取得

response = webmasters_service.searchanalytics().query(siteUrl=SITE_URL, body=request).execute()

# データフレームの作成

rows = response.get('rows', [])

data = []

for row in rows:

keys = row['keys']

data.append([keys[0], row['clicks'], row['impressions'], row['ctr'], row['position']])

df = pd.DataFrame(data, columns=['query', 'clicks', 'impressions', 'ctr', 'position'])

# データの表示

print(df.head())

データ抽出の自動化手法とその利点

データ抽出の自動化により、定期的なレポート作成が簡便になります。スケジュールタスクやクラウドサービスを利用して定期的にスクリプトを実行することで、最新のデータを自動的に取得し、分析に役立てることができます。

データのクレンジングと前処理の重要性

データ抽出後には、欠損値の処理や異常値の検出、データの正規化などのクレンジングと前処理が必要です。これにより、分析結果の精度を高めることができます。

具体的なデータ抽出プロセスの解説

具体的なデータ抽出プロセスは、以下の手順で進めます:

1. Google Cloud Consoleでプロジェクトを作成し、APIキーを取得。

2. Python環境をセットアップし、必要なライブラリをインストール。

3. 認証情報を設定し、APIを通じてデータを取得。

4. データをクレンジングし、前処理を行う。

これらの手順を踏むことで、効率的かつ正確なデータ抽出が可能になります。

エンベディングとクラスタリングの手法:データの理解と実装

エンベディングとクラスタリングは、データの次元を圧縮し、類似性に基づいてデータをグループ化する手法です。これにより、大量のデータから重要なパターンや傾向を抽出することが可能になります。以下では、エンベディングの基本概念とクラスタリング手法の実装について解説します。

エンベディングとは何か?その基本概念と重要性

エンベディングは、高次元データを低次元空間に変換する手法です。これにより、データの構造を保持しつつ、計算コストを削減し、視覚的に理解しやすい形式に変換します。例えば、検索クエリをエンベディングすることで、クエリ間の類似性を計算しやすくなります。

クラスタリング手法の種類と選び方

クラスタリング手法には、K-meansクラスタリング、階層的クラスタリング、DBSCANなどがあります。それぞれの手法には特性があり、データの特性や目的に応じて適切な手法を選ぶことが重要です。

Pythonを用いたエンベディングとクラスタリングの実装

以下は、Pythonを用いたエンベディングとクラスタリングのサンプルコードです。ここでは、TF-IDFを用いて検索クエリをエンベディングし、K-meansクラスタリングを適用します。

# エンベディングとクラスタリングのサンプルコード

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.cluster import KMeans

import pandas as pd

# データの読み込み

data = pd.read_csv('search_queries.csv')

# エンベディングの実行

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(data['query'])

# クラスタリングの実行

kmeans = KMeans(n_clusters=5, random_state=0).fit(X)

# クラスタリング結果の追加

data['cluster'] = kmeans.labels_

# クラスタごとの代表クエリの表示

for cluster in range(5):

print(f'Cluster {cluster}:')

print(data[data['cluster'] == cluster]['query'].head(10))

実際のデータを用いたクラスタリング手法の適用例

実際のデータを用いたクラスタリング手法の適用例として、検索クエリのクラスタリングを行い、各クラスタの代表クエリを抽出します。これにより、ユーザーの検索意図や行動パターンを明確に理解することができます。

結果の評価と次のステップ

クラスタリング結果を評価するためには、シルエットスコアなどの指標を用います。これにより、クラスタの質を評価し、必要に応じてパラメータの調整や再クラスタリングを行います。次のステップとして、クラスタごとの改善施策を策定し、実行することが求められます。

可視化技術を用いたデータ分析の結果とその応用方法

データの可視化は、分析結果を視覚的に表現することで、理解しやすくし、洞察を得るための重要な手段です。可視化技術を用いることで、データのパターンやトレンドを迅速に把握し、効果的な意思決定を支援します。以下では、データ可視化の基本原則と具体的な実例について解説します。

データ可視化の基本原則とツールの選び方

データ可視化の基本原則としては、以下の点が重要です:

1. シンプルで明確な表現:過度に複雑なグラフやチャートは避け、シンプルで明確な表現を心掛けます。

2. 適切なツールの選定:データの特性に応じて適切な可視化ツールを選びます。Pythonのmatplotlibやseaborn、Tableau、Power BIなどが代表的です。

3. 一貫性のあるデザイン:フォントや色の一貫性を保ち、視覚的な混乱を避けます。

Pythonを用いたデータ可視化の実例

Pythonを用いたデータ可視化の実例として、matplotlibとseabornを用いたグラフ作成を紹介します。以下のコードでは、クラスタごとのインプレッション数とクリック数の時系列データを可視化しています。

# データ可視化のサンプルコード

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

# データの読み込み

data = pd.read_csv('search_console_data.csv')

# クラスタごとの日別インプレッション数とクリック数の集計

daily_data = data.groupby(['date', 'cluster']).sum().reset_index()

# インプレッション数の可視化

plt.figure(figsize=(14, 7))

sns.lineplot(data=daily_data, x='date', y='impressions', hue='cluster', palette='tab10')

plt.title('Daily Impressions by Cluster')

plt.xlabel('Date')

plt.ylabel('Impressions')

plt.show()

# クリック数の可視化

plt.figure(figsize=(14, 7))

sns.lineplot(data=daily_data, x='date', y='clicks', hue='cluster', palette='tab10')

plt.title('Daily Clicks by Cluster')

plt.xlabel('Date')

plt.ylabel('Clicks')

plt.show()

インサイトを引き出すための可視化手法

データ可視化を通じてインサイトを引き出すためには、適切なグラフやチャートを選ぶことが重要です。例えば、時系列データには折れ線グラフ、カテゴリデータには棒グラフやヒートマップが適しています。また、複数の変数を比較する場合には散布図を用いると効果的です。

可視化結果を用いたビジネスインテリジェンスの向上

可視化結果は、ビジネスインテリジェンスの向上に大きく貢献します。データのトレンドやパターンを視覚的に捉えることで、経営層や関係者に対して効果的に情報を伝えることができます。これにより、迅速かつ的確な意思決定が可能になります。

実際の可視化結果とその解釈

実際の可視化結果を基に、具体的な解釈を行います。例えば、特定の期間にインプレッション数が急増したクラスタについて、その要因を分析し、成功事例として取り上げることができます。以下は、クラスタごとのインプレッション数とクリック数の可視化結果を基にした解釈の例です。

クリック数の改善ポイントと今後の課題について

クリック数の改善は、ウェブサイトのパフォーマンスを向上させるための重要な施策です。以下では、クリック数を改善するための具体的な方法と、今後の課題について解説します。

クリック数を改善するための具体的な方法

クリック数を改善するためには、以下の方法が有効です:

1. メタデータの最適化:ページタイトルやメタディスクリプションをユーザーにとって魅力的なものに変更します。

2. コンテンツの質の向上:ユーザーが求める情報を提供する高品質なコンテンツを作成します。

3. 内部リンクの最適化:関連するページへのリンクを適切に配置し、ユーザーのサイト内移動を促進します。

4. モバイルフレンドリーなデザイン:モバイルユーザー向けにデザインを最適化し、クリックしやすい環境を提供します。

過去のデータから学ぶ成功事例と失敗例

過去のデータを分析することで、成功事例と失敗例を学び、効果的な改善策を見出すことができます。例えば、特定の期間にクリック数が増加したページの要因を分析し、他のページにも適用することで全体のクリック数を向上させることができます。

改善ポイントの継続的なモニタリングと調整

クリック数の改善は一度きりの施策ではなく、継続的なモニタリングと調整が必要です。定期的にデータを分析し、効果を評価して、必要に応じて施策を見直します。これにより、長期的なパフォーマンス向上が期待できます。

技術的な対策とコンテンツ改善のバランス

技術的な対策(SEOの技術的側面)とコンテンツ改善(ユーザーにとっての価値提供)のバランスを取ることが重要です。例えば、ページの読み込み速度を向上させる技術的対策と、ユーザーが求める情報を提供するコンテンツ改善を同時に行うことで、クリック数の大幅な向上が期待できます。

今後のSEO戦略における主要課題とその対応策

今後のSEO戦略における主要課題としては、アルゴリズムの変更への対応や、競合サイトの分析と対策が挙げられます。これらの課題に対しては、最新のSEOトレンドを常にキャッチアップし、柔軟に対応することが求められます。

# クリック数改善のサンプルコード

import pandas as pd

import matplotlib.pyplot as plt

# データの読み込み

data = pd.read_csv('search_console_data.csv')

# 特定のページのクリック数の推移を可視化

page_data = data[data['page'] == 'https://www.example.com/specific-page']

plt.figure(figsize=(14, 7))

plt.plot(page_data['date'], page_data['clicks'], marker='o')

plt.title('Clicks Over Time for Specific Page')

plt.xlabel('Date')

plt.ylabel('Clicks')

plt.show()

ピラーコンテンツとクラスターコンテンツの効果的な活用方法

ピラーコンテンツとクラスターコンテンツは、SEO戦略の中で重要な役割を果たします。ピラーコンテンツは大きなテーマを扱い、クラスターコンテンツはそのテーマに関連する詳細な記事を提供します。この二者を効果的に活用することで、ユーザーの興味を引き、SEOパフォーマンスを向上させることができます。

ピラーコンテンツの役割とその作成方法

ピラーコンテンツは、ウェブサイトの中核となるテーマを包括的に取り扱う記事です。このコンテンツは、ユーザーが求める基本的な情報を網羅し、詳細な説明やガイドを提供します。ピラーコンテンツを作成する際には、以下のポイントに注意します:

1. 包括的な情報提供:ユーザーが求めるすべての基本情報を提供します。

2. 視覚的な要素の活用:図表や画像を用いて情報を分かりやすくします。

3. 内部リンクの設置:関連するクラスターコンテンツへのリンクを設置し、ユーザーのサイト内移動を促します。

クラスターコンテンツの重要性と最適な配置方法

クラスターコンテンツは、ピラーコンテンツで取り扱ったテーマに関連する詳細な記事です。これにより、ユー

ザーは深掘りした情報を得ることができ、サイト全体のSEO効果が向上します。クラスターコンテンツの最適な配置方法としては、以下の点が挙げられます:

1. 関連性の高いリンク設置:クラスターコンテンツ同士やピラーコンテンツへのリンクを設置します。

2. カテゴリ別の整理:クラスターコンテンツをカテゴリ別に整理し、ユーザーが情報を探しやすくします。

3. 定期的な更新:最新情報を提供するために、クラスターコンテンツを定期的に更新します。

内部リンク構造の最適化によるSEO効果の向上

内部リンク構造を最適化することで、SEO効果を大幅に向上させることができます。内部リンクは、Googleのクローラーがサイト内を効率的にクロールし、インデックスするのを助けます。以下は、内部リンク構造の最適化手法です:

1. 関連ページへのリンク設置:関連するページや記事へのリンクを設置し、ユーザーの滞在時間を延ばします。

2. アンカーテキストの最適化:リンクのアンカーテキストに適切なキーワードを含めることで、SEO効果を高めます。

3. サイトマップの活用:XMLサイトマップを作成し、Google Search Consoleに送信することで、効率的なインデックスを促します。

コンテンツマーケティングにおけるピラー&クラスター戦略の成功例

ピラー&クラスター戦略を成功させるための実例として、特定のテーマに関する包括的なピラーコンテンツを作成し、そのテーマに関連する詳細なクラスターコンテンツを提供するケースがあります。これにより、ユーザーの検索意図に応じた情報を提供し、サイト全体のエンゲージメントを高めることができます。

具体的な施策と実行手順

具体的な施策としては、以下の手順で進めます:

1. テーマの選定:ピラーコンテンツのテーマを選定し、関連するクラスターコンテンツのリストを作成します。

2. コンテンツの作成:ピラーコンテンツとクラスターコンテンツを作成し、適切な内部リンクを設置します。

3. 定期的な更新:コンテンツを定期的に更新し、最新情報を提供します。

# 内部リンク構造の最適化サンプルコード

from bs4 import BeautifulSoup

import requests

# ウェブページの取得

url = 'https://www.example.com'

response = requests.get(url)

soup = BeautifulSoup(response.content, 'html.parser')

# 内部リンクの抽出

internal_links = [a['href'] for a in soup.find_all('a', href=True) if 'example.com' in a['href']]

# 内部リンクの表示

for link in internal_links:

print(link)