データマイニングとは?定義とその重要性について詳しく解説

目次

データマイニングとは?定義とその重要性について詳しく解説

データマイニングとは、大量のデータの中から有用な情報や知識を自動的に発見する手法を指します。従来は専門的な分析能力が必要とされていましたが、近年ではツールの進化により、より多くの分野で活用されるようになっています。企業にとっては、売上向上やコスト削減、顧客理解の深化などの目的で利用されることが多く、データドリブンな意思決定を支える重要な役割を果たしています。近年のビッグデータやAIの進展により、その活用範囲と影響力はさらに拡大しており、現代ビジネスにおいては欠かせない技術となりつつあります。

データマイニングの定義と基本的な考え方を解説

データマイニングは、膨大なデータの中からパターンや関係性を見つけ出し、有益な知見を抽出するプロセスを指します。単なるデータの集計や可視化とは異なり、統計学や機械学習の技術を活用して、潜在的な規則性や将来の傾向を予測することが可能です。主な考え方としては、「未知の知識の発見」が中核にあり、既存の仮説にとらわれずにデータを探索する点に特徴があります。また、業種や分野に応じて目的やアプローチが異なるため、柔軟な適用が求められる分野でもあります。

ビジネスや学術分野で注目される理由と背景とは

ビジネスの現場では、膨大な顧客データや取引履歴が日々蓄積されています。これらを単なる履歴として扱うのではなく、利益につながるインサイトとして活用するために、データマイニングが注目されています。例えば、購買パターンからリピート率を高める施策を導き出したり、不正の兆候を早期に察知したりする応用が可能です。また、学術分野では社会科学や医学、教育など多くの分野で活用が進んでおり、大量データを基に新たな仮説を導き出すための基盤技術として重要視されています。

統計解析やAIとの違いと共通点について知ろう

データマイニングと統計解析、AI(人工知能)は密接に関係していますが、それぞれ目的や適用範囲に違いがあります。統計解析は仮説検証が主目的であるのに対し、データマイニングは仮説なしでもパターンを発見する探索的手法です。一方AIは、予測や判断などの知的なタスクを機械で行う技術全般を指し、データマイニングはその一部として活用されることがあります。共通点としては、いずれもデータから価値を見出すという点にありますが、適用場面やアプローチの違いを理解することが活用の鍵となります。

データマイニングが果たす役割と期待される効果

データマイニングは、企業の意思決定を支える強力な武器となります。例えば、顧客の購買履歴から好みを分析し、パーソナライズされたマーケティングを展開することで、売上やLTV(顧客生涯価値)を向上させることが可能です。また、異常値の検知による不正防止や、在庫管理の最適化など業務効率化にも寄与します。データマイニングによって得られるインサイトは、従来の経験則や直感に頼る意思決定と比べ、根拠のある施策を導く基盤となり、競争優位性の確立に貢献します。

重要性が高まる現代社会での活用シーンとは

現代社会では、あらゆる活動がデータ化されつつあります。スマートフォンの利用履歴、SNSの投稿、IoTデバイスからのセンサーデータなど、分析可能な情報が飛躍的に増加しています。こうした背景から、データマイニングは単なる企業活動にとどまらず、公共政策や教育、医療、環境など多岐にわたる分野で活用されるようになっています。たとえば、交通渋滞の予測、感染症の拡大リスク分析、教育成果の可視化などがその代表例です。これらのシーンにおいて、社会全体の効率性や安全性を高めるための重要な技術となっています。

初心者でもわかるデータマイニングの概要と仕組み

データマイニングの概要を理解することは、ビジネスや研究などあらゆる分野での応用に不可欠です。データマイニングは、大量のデータの中から意味のある情報を抽出し、意思決定に活かす手法です。これは統計学や機械学習、AIの技術を活用しながら、未知のパターンや相関関係を発見することを目的とします。初心者にとって重要なのは、どのような目的で、どのような種類のデータを扱うのかを明確にすることです。構造化データだけでなく、画像やテキストといった非構造化データに対しても分析が可能になってきており、ますます多様な分野での適用が進んでいます。

データマイニングの基本的な流れとステップを紹介

データマイニングのプロセスは、一般的に「目的の明確化」「データの収集と前処理」「モデリング」「評価」「実装と展開」というステップで構成されます。まず、何を明らかにしたいのかという明確な目標を設定し、それに応じたデータを収集します。次に、欠損値や異常値の処理、変数の変換など前処理を行い、分析可能な形式に整えます。その後、目的に応じて分類・回帰・クラスタリングなどのアルゴリズムを適用し、モデルを構築します。構築したモデルの性能を評価し、必要に応じてチューニングを行ったうえで、業務に実装していきます。

使用される代表的なデータソースとその種類について

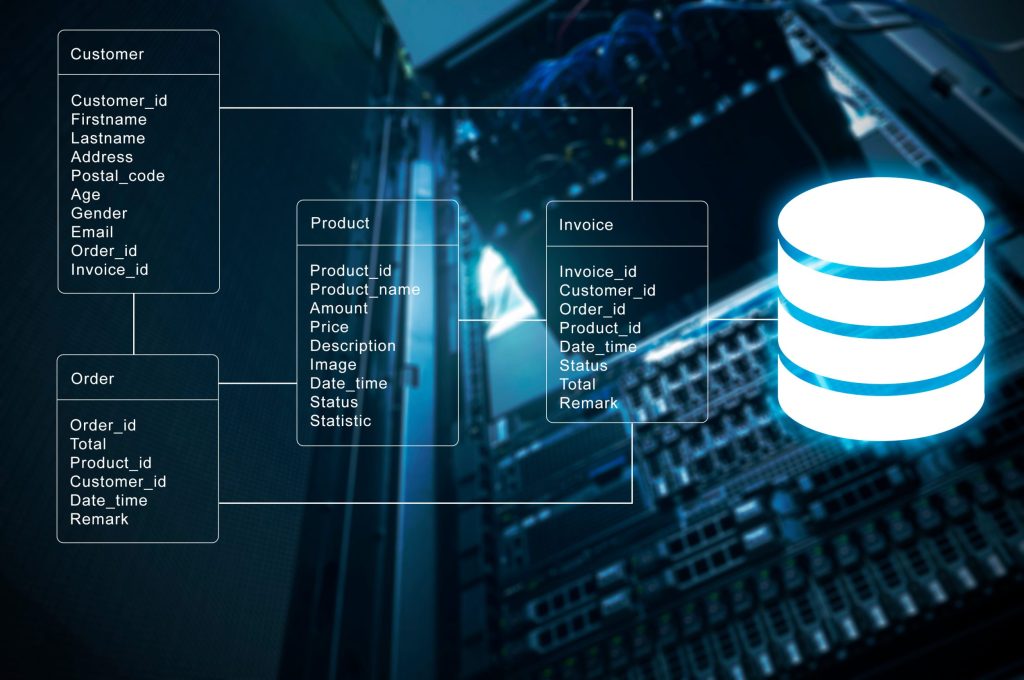

データマイニングに利用されるデータソースには、構造化データと非構造化データの2種類があります。構造化データとは、行と列で整理された形式のデータで、データベースやExcelなどが典型的な例です。これに対して非構造化データは、文章、画像、動画、音声など決まった形式を持たないデータです。たとえば、SNS投稿の文章やレビュー、カメラ映像などが該当します。近年では、IoTデバイスから取得されるセンサーデータや、ログデータなども重要なデータソースとなっています。これらの多様な情報を収集・統合し、分析に活かすことで、より深いインサイトを得ることが可能となります。

分析に必要な前処理やデータクレンジングとは

データマイニングにおいて、前処理は非常に重要な工程です。生データには、欠損値や重複、誤入力、異常値などの「ノイズ」が含まれていることが多く、そのままでは正確な分析ができません。そのため、まずは欠損値の補完、外れ値の除去、フォーマットの統一、カテゴリ変数の数値化などを行います。これらの作業を「データクレンジング」とも呼びます。また、スケーリングや正規化、次元削減などの処理を施すことで、モデルの精度や処理速度の向上が図れます。質の高い前処理は、高性能な分析モデルの構築に直結するため、決して手を抜いてはいけない重要なフェーズです。

データマイニングの処理手法とツールの関係性

データマイニングでは、処理手法に応じて様々なツールが活用されます。例えば、クラスタリングや分類にはPythonのscikit-learn、統計解析にはR、ビジュアルな操作が求められる場合はTableauやOrangeなどが選ばれます。また、Google CloudやAWSなどクラウドベースのプラットフォームでも高度な分析処理が可能です。ツール選定の際には、目的とする分析内容、取り扱うデータの種類、チームの技術力などを踏まえて選ぶことが大切です。これにより、効率的かつ正確なマイニング処理が可能となり、業務への導入もしやすくなります。

業務への適用を見据えた概要理解のポイント

データマイニングを業務で活用するには、単なる技術理解にとどまらず、現場での具体的な活用イメージを持つことが重要です。たとえば、マーケティング部門であれば顧客の購買パターン分析、営業部門では成約確率の予測、人事部門では離職リスクの分析など、部門ごとに求められるアウトカムが異なります。そのため、どのようなデータが手元にあり、どの業務フローに組み込めるのかを理解しておく必要があります。また、分析結果を業務に落とし込む際には、現場の理解と協力が不可欠であり、わかりやすく説明できるスキルも求められます。

代表的なデータマイニング手法とその特徴・用途とは

データマイニングにはさまざまな手法が存在し、それぞれの手法が特定の目的やデータの特性に応じて活用されます。例えば、クラスタリングはデータをグループ化するための手法であり、マーケティングなどで顧客をセグメントに分ける際に有効です。一方、分類や回帰といった予測型手法は、未来の行動や数値を予測するために使用され、ビジネスにおける意思決定を支える重要な技術です。また、アソシエーション分析や異常検知など、用途に応じた手法も数多く存在します。ここでは、代表的なデータマイニング手法について、その概要と特徴、活用シーンを詳しく紹介します。

クラスタリング手法の基本と代表的アルゴリズム

クラスタリングは、ラベル付けされていないデータを、類似性に基づいてグループに分ける「非教師あり学習」の一種です。たとえば顧客の購買履歴やアクセスログをもとに、嗜好が似ているユーザー群を自動的に分類することができます。代表的なクラスタリング手法には「K-means法」「階層的クラスタリング」「DBSCAN」などがあります。K-means法はシンプルで高速なため、多くの用途に適していますが、クラスタ数を事前に指定する必要がある点が特徴です。マーケティングや商品企画、レコメンドシステムなどにおいて、潜在的なセグメントを抽出する場面で重宝されます。

分類(分類木やSVMなど)による予測モデリング

分類は、データにあらかじめ与えられたカテゴリ(ラベル)を予測する「教師あり学習」の代表的手法です。たとえば、メールを「スパム」または「通常」に分類したり、顧客が「解約するか否か」を予測したりする際に使われます。代表的なアルゴリズムには「決定木(Decision Tree)」「ランダムフォレスト」「サポートベクターマシン(SVM)」などがあり、それぞれにメリットと適用シーンがあります。決定木は視覚的な理解がしやすく、SVMは高次元データでも高い精度を誇る点が特長です。分類手法は、ビジネス予測やリスク管理、医療診断など幅広い分野で活用されています。

アソシエーション分析とマーケットバスケット分析

アソシエーション分析とは、項目間の同時出現関係を明らかにする手法で、特に「マーケットバスケット分析」として知られています。これは、スーパーマーケットなどで「商品Aを購入した人は商品Bも買う傾向がある」といった関係性を発見するために用いられます。代表的なアルゴリズムとして「Apriori法」や「FP-Growth法」などがあり、いずれも項目の頻度と信頼度(Confidence)をもとにルールを導き出します。この分析は、レコメンデーションの精度向上、クロスセル・アップセルの最適化、商品の棚配置の改善など、実務的な応用に直結する強力なツールです。

回帰分析を用いた数量予測とその応用例

回帰分析は、ある変数(目的変数)が他の変数(説明変数)にどう影響されるかを数値的にモデル化する手法です。特に、将来の売上や気温、価格などの「連続値」を予測する場面で用いられます。最も基本的なのは「線形回帰」であり、複数の変数を扱う「重回帰分析」や、非線形な関係を扱う「ロジスティック回帰」などもあります。ビジネスでは、需要予測、価格戦略の最適化、キャンペーン効果の分析などに活用されています。回帰分析の精度を高めるためには、適切な変数の選定や多重共線性の確認、モデルの評価が重要となります。

異常検知によるリスク管理や不正対策への応用

異常検知は、通常のパターンとは異なるデータポイントを識別することで、リスクや不正行為の兆候を早期に察知する手法です。具体的には、金融取引における不正利用の検出、製造業における装置の異常予知、サイバー攻撃の兆候分析などに活用されています。技術的には、「統計的手法」「機械学習による予測モデル」「距離ベースの分析」などがあります。例えば、観測されたデータが平均から大きく外れていれば、それは「異常」と判断される可能性があります。リアルタイム性が求められる分野では特に重要であり、継続的な学習と精度改善も鍵となります。

成果を出すためのデータマイニング活用のポイントとは?

データマイニングは、その技術力だけで成果が出るものではなく、活用の目的や現場での実装、継続的な運用体制までを含めてトータルに設計することが重要です。どれだけ精緻な分析モデルを構築しても、ビジネス課題に結び付かなければ価値は生まれません。そのためには、明確な目標設定、適切なデータ前処理、アルゴリズムの選定、実行可能なアウトプットの設計が求められます。さらに、分析結果を現場で活かすには、可視化やレポートの工夫、関係者との連携、定期的な改善の仕組みも不可欠です。ここでは、成果に直結するデータマイニング活用の5つのポイントを紹介します。

明確な目的設定とKPIの設計が成功の鍵となる

データマイニングのプロジェクトでは、最初の段階で「何を達成したいのか」という目的を明確に定義することが、成功の鍵を握ります。目的が曖昧なまま分析を進めると、結果として「何がわかったのか」が不明瞭になり、現場での活用に繋がりません。目的とともに重要なのがKPI(主要業績評価指標)の設計です。たとえば「解約率を10%削減する」「クロスセル率を20%向上させる」など、具体的で測定可能な指標があることで、分析の方向性が明確になります。また、KPIの達成可否を定量的に検証できることで、成果の可視化やPDCAサイクルの確立にも役立ちます。

質の高いデータ収集と前処理工程の重要性

データマイニングの成果を左右する最大の要素は「データの質」です。いくら高性能なアルゴリズムを使っても、入力されるデータに誤りや欠損、バイアスが含まれていては正確な分析結果は得られません。そのため、信頼性の高いデータ収集方法を確立し、分析に適した形に整える「前処理工程」が不可欠です。具体的には、不要なデータの除去、異常値の処理、変数の正規化、カテゴリ変数のエンコードなどが行われます。また、データ取得の段階での整合性確認や、更新の自動化も重要です。こうした前段階を丁寧に行うことが、モデルの精度や実用性を大きく左右します。

適切なアルゴリズムの選定とチューニングの工夫

データマイニングでは、目的やデータの特性に応じて最適なアルゴリズムを選ぶ必要があります。例えば、分類問題であれば決定木やSVM、数値予測であれば回帰分析やランダムフォレスト、グループ分けにはクラスタリングなどがあります。ただし、どのアルゴリズムも万能ではなく、モデルの性能を最大化するには「チューニング」と呼ばれる調整が必要です。これは、ハイパーパラメータの最適化や交差検証の実施、特徴量エンジニアリングなどを含みます。ツールによってはAutoML(自動機械学習)機能も活用でき、専門知識がなくてもチューニングが可能なケースも増えています。

実行可能なアクションプランへの落とし込み方法

データマイニングの分析結果を実際の施策に活かすには、「実行可能なアクション」に落とし込むプロセスが不可欠です。たとえば、顧客の解約リスクが高いと予測された場合、その顧客に対するフォロー施策をどう実施するかを具体化する必要があります。その際には、マーケティング担当者や営業チームと連携し、現場で対応可能な範囲で施策設計を行うことが求められます。また、分析結果を経営層に報告する際には、視覚化や要点整理を行い、意思決定に活かせるようにすることが重要です。数字だけでなく「何をすべきか」が明確な提案が求められます。

継続的な評価と改善プロセスの導入が成果を生む

データマイニングは一度きりの分析で終わるものではなく、継続的な評価と改善を繰り返すことで真の価値を発揮します。たとえば、初回の分析で構築したモデルが半年後には劣化し、現状に合わなくなることもあります。こうした変化に対応するために、定期的にモデルの精度を評価し、必要に応じて再学習やチューニングを行う体制が求められます。また、分析によって得られた知見がどのような業務改善や成果につながったかを振り返り、次の施策に活かすことも重要です。このサイクルを仕組みとして業務に取り込むことで、データマイニングは継続的な成長エンジンとなります。

業界別に見るデータマイニングのユースケースと事例紹介

データマイニングは、業界ごとに異なる課題解決に応用され、実際に成果を上げている事例が多数存在します。たとえば小売業では購買履歴を基にしたレコメンドや在庫管理、金融では与信判断や不正検出、製造業では設備保全や品質管理など、業界ごとのニーズに応じて適用が進んでいます。医療や教育、物流、エネルギー分野においても、データの活用によってサービスの最適化やコスト削減が実現されています。本節では、各業界でどのようにデータマイニングが導入され、どのような成果を上げているかを具体的なユースケースを通じて紹介します。

小売業界における購買履歴からの需要予測活用事例

小売業界では、データマイニングを用いて顧客の購買履歴や来店データを分析し、商品の需要を予測する取り組みが進んでいます。たとえば、大手スーパーでは過去の販売データと気象データを組み合わせて、天候や季節による需要の変動を予測し、適切な発注量を決定しています。これにより在庫ロスの削減と機会損失の防止を両立し、収益向上に貢献しています。また、顧客の購買傾向から個別におすすめ商品を提示するレコメンド機能も、データマイニングによって精度が高まり、販売促進に寄与しています。小売業では特に、リアルタイムでの分析と施策連動が成功の鍵となります。

金融業界での信用スコアリングや不正検出の応用

金融業界においては、信用リスクの評価や不正取引の検出にデータマイニングが広く活用されています。信用スコアリングでは、申込者の年収、職業、既存ローン情報、取引履歴など多様なデータを元に、返済能力やリスクをモデル化します。これにより与信判断が客観的かつ迅速に行えるようになります。また、不正検出では、通常の取引パターンから逸脱する異常をリアルタイムで見つけるアルゴリズムが導入され、クレジットカードの不正利用やマネーロンダリングの兆候を検知する役割を果たしています。正確かつ高速な意思決定が求められる金融分野において、データマイニングは必須のテクノロジーとなっています。

製造業における故障予知や生産最適化の取り組み

製造業では、生産設備や製品の品質データを活用した「故障予知」や「予防保全」が注目されています。IoTセンサーを用いてリアルタイムに収集されたデータを分析することで、通常とは異なる挙動をいち早く察知し、故障が発生する前にメンテナンスを実施することが可能になります。これにより、ダウンタイムを最小限に抑え、生産性を維持できます。また、生産ラインにおけるボトルネックの特定や、歩留まりの改善にもデータマイニングは有効です。さらに、需要予測と連携させることで、過剰在庫や欠品のリスクも低減可能となり、経営全体の最適化に貢献しています。

医療・ヘルスケア分野での診断支援や予測分析

医療分野では、電子カルテや検査データ、バイタル情報など膨大なデータをもとに、診断支援や疾病予測を行う取り組みが進んでいます。たとえば、過去の患者データを学習させたモデルを用いて、がんの早期発見や再発リスクの予測を支援するシステムが導入されています。加えて、治療効果の予測や副作用の発現リスクを評価することで、個別最適な医療提供も実現しつつあります。こうしたデータ活用により、医師の判断精度を高めるだけでなく、医療現場の効率化や患者満足度の向上にもつながっています。ビッグデータとAIの融合により、医療の質と安全性が大きく変革しつつあります。

教育分野での学習履歴解析と個別最適化の試み

教育分野では、学生一人ひとりの学習履歴やテスト結果、ログイン履歴などをもとに、学習の進捗や理解度を可視化し、指導に役立てる取り組みが始まっています。データマイニングにより、成績の推移から将来的な学力の伸びやドロップアウトリスクを予測し、早期に介入することが可能となります。また、適性や得意・不得意分野を判定し、個別最適化された教材やカリキュラムの提供も行われています。これにより、教師はより精緻な指導ができるようになり、生徒側のモチベーションや学習効果の向上にも繋がります。EdTechの進展に伴い、教育分野でのデータマイニング活用は今後さらに加速していくでしょう。

進化し続けるデータマイニング技術と将来の展望

データマイニング技術は、AIやビッグデータ、クラウドコンピューティングの進展とともに急速に進化を遂げています。これまで専門家にしか扱えなかった分析手法が、ツールの高度化により一般のビジネスユーザーにも利用可能になっており、意思決定のスピードと精度が飛躍的に向上しています。また、リアルタイムデータや非構造化データの処理能力も大きく向上しており、より複雑なパターンの抽出が可能となりました。今後は、自動化・民主化・高速化をキーワードに、より多くの分野での適用が期待されます。本節では、データマイニングの技術的な進化とその将来像を多角的に解説します。

機械学習との統合による分析精度の向上トレンド

近年のデータマイニング技術の大きな進化のひとつに、機械学習との融合があります。特に、教師あり学習や教師なし学習を応用したモデルは、従来の統計的手法と比較して高い精度と柔軟性を発揮しています。例えば、ランダムフォレストや勾配ブースティング(XGBoostなど)といった手法は、分類や予測タスクで非常に優れた性能を示します。さらに、機械学習モデルのハイパーパラメータを自動で調整するAutoML技術も登場しており、分析スキルがなくても高性能なモデル構築が可能になってきています。今後も機械学習との連携によって、データマイニングの精度と応用力はさらに進化していくでしょう。

クラウドサービスの普及による利便性の拡大

クラウドサービスの台頭により、データマイニングはより手軽でスケーラブルなものとなっています。Google Cloud Platform、AWS、Microsoft Azureなどの主要クラウドでは、ビッグデータ解析や機械学習サービスを標準搭載しており、ユーザーは複雑なインフラを用意することなく、高度なデータ処理を行うことができます。また、クラウド上でのデータ統合・分析・可視化が可能になったことで、複数部門や拠点にまたがるコラボレーションも容易になりました。加えて、従量課金制やAPI連携の柔軟性など、コスト面や拡張性のメリットも大きく、今後さらに多くの企業がクラウドベースのデータマイニング環境を導入していくと予想されます。

リアルタイム分析とストリーミング処理の進化

IoTやウェブアクセスログ、金融取引など、リアルタイムで発生する大量のデータを分析するニーズが急速に高まっています。これに応える形で、Apache KafkaやApache Flinkといったストリーミング処理基盤が発展し、リアルタイムでのデータマイニングが現実のものとなっています。たとえば、センサーデータをもとに設備の異常兆候を即時に検知したり、SNSのトレンドを即座に分析してマーケティング施策に反映する事例も増えています。リアルタイム分析は、意思決定のスピードと柔軟性を飛躍的に向上させるだけでなく、従来では見逃されていた瞬間的なパターンを捉える上でも重要な技術です。

自動化ツールとAutoMLによる民主化の進展

データマイニングの自動化を可能にするツールの登場により、専門知識がなくても高度な分析を行える環境が整ってきています。AutoMLはその代表例で、データの前処理から特徴量選定、モデル選択、ハイパーパラメータの最適化までを自動で行ってくれるため、分析者のスキルに依存せず高精度な結果を得ることができます。Google Cloud AutoMLやMicrosoft Azure ML Studioなどのサービスは、直感的なUIで操作できるため、現場の担当者でも扱いやすいのが特徴です。こうしたツールの普及により、データ分析は一部の専門家だけでなく、ビジネスユーザーや現場担当者へと広がりつつあります。

倫理・プライバシー問題と今後の規制動向への備え

データマイニングの高度化と活用の拡大に伴い、プライバシーや倫理に関する課題も顕在化しています。たとえば、個人情報を含むデータの分析では、GDPR(EU一般データ保護規則)や日本の個人情報保護法といった法規制に準拠する必要があります。また、AIバイアスや差別的な判断を招かないよう、使用するデータの内容やモデルの公平性を十分に確認することが求められています。今後は、説明可能なAI(XAI)やフェアネス指標の導入など、倫理的な側面を考慮した技術の開発がますます重要となるでしょう。組織としても、透明性のあるデータ活用方針と監査体制を整備することが求められます。

製造・流通・医療など産業界における応用事例まとめ

データマイニングは、さまざまな産業分野において既に多くの成果を上げており、今や業務改善や意思決定に不可欠な存在となっています。製造業では設備保全や品質管理、流通業では物流最適化や需要予測、医療分野では診断支援や予防医療の分野で広く活用されています。データが蓄積されるだけでは意味を持ちませんが、そこからパターンや知見を抽出し、現場に反映させることで真の価値が生まれます。ここでは各産業における具体的なデータマイニングの応用事例を通じて、その有用性とインパクトを明らかにします。

サプライチェーンの最適化に貢献する分析事例

サプライチェーンの最適化は、多くの企業にとって重要な課題であり、データマイニングはその解決に大きな役割を果たします。たとえば、受発注履歴、天候情報、交通状況、販売予測などの複数のデータを統合・分析することで、調達から配送までのプロセスを効率化できます。あるグローバルメーカーでは、過去の在庫推移と販売データを機械学習で分析し、需要変動に応じた自動発注システムを導入しました。これにより欠品と在庫過剰のリスクを大幅に削減し、コストの最適化と納期遵守率の向上を同時に実現しています。複雑なサプライチェーンの可視化と予測に、データマイニングは欠かせない武器となっています。

在庫管理と需要予測によるコスト削減への活用

在庫管理の効率化は、物流・小売・製造業のいずれにおいてもコスト構造に大きな影響を与える重要な要素です。データマイニングを活用すれば、過去の売上データや時期ごとの需要変動を基に、最適な在庫量を導き出すことが可能です。たとえば、大手アパレル企業では、各店舗の販売履歴と気象データをもとに、次週の販売数量を予測し、補充数を自動決定する仕組みを導入しています。これにより、機会損失を防ぎながら在庫回転率を向上させ、結果的に倉庫コストと廃棄ロスの削減に成功しました。予測精度の向上により、人的作業に頼らない効率的な在庫運用が可能となります。

製品品質の管理と異常検知を用いた実践例

製品品質の安定化と不良品の早期発見は、製造業にとって最も重要な課題の一つです。センサーや検査装置から得られる膨大な工程データをデータマイニングで分析することで、異常の兆候を検知し、トラブルの発生を未然に防ぐことが可能です。たとえば、自動車部品メーカーでは、生産ラインの温度、圧力、加工時間などの変動をリアルタイムで監視し、正常時と異なる挙動を自動で検出する仕組みを構築しました。異常が検知された際にはアラートが出され、即時に対応が取られます。これにより、重大な不具合の連鎖を防ぎ、品質保証体制の強化とブランド価値の向上に貢献しています。

患者データを活用した診療効率の向上支援

医療分野では、患者の診療データ、処方履歴、検査結果といった大量の情報を分析することで、診療の効率化や精度向上が図られています。特に、診療記録をもとにした「診断支援システム」や、入院患者の再入院リスク予測モデルなどが注目を集めています。ある病院では、過去の症例データを機械学習モデルで分析し、特定の症状に対する効果的な治療パターンを導出。それを活用することで、医師の診療判断をサポートし、治療方針の最適化や再診率の低下を実現しました。さらに、医療スタッフの業務負担の軽減にもつながり、より患者中心の医療提供体制が整備されています。

物流における配送ルート最適化と時間短縮事例

物流業界では、輸送ルートの最適化や配送時間の短縮が企業の競争力に直結します。データマイニングを活用することで、交通状況、過去の配送実績、天候情報、顧客の在宅傾向などをもとに、最適なルートをリアルタイムで導き出すことが可能です。たとえば、大手宅配企業では、AIによるルート選定システムを導入し、交通渋滞を避けつつ複数の配達先を効率良く巡回する方法を自動で算出しています。その結果、燃料費や走行距離の削減、時間の短縮だけでなく、ドライバーの負荷軽減にも繋がっています。環境配慮の観点からも、持続可能な物流体制の実現に貢献しています。

データマイニングで活用される注目の10大アルゴリズム

データマイニングの効果を最大限に引き出すには、目的に応じて最適なアルゴリズムを選定することが重要です。分類や回帰、クラスタリング、アソシエーション分析、異常検知など、用途に応じて多種多様な手法が存在します。その中でも特に使用頻度が高く、実用性が認められている代表的なアルゴリズムがいくつかあります。これらのアルゴリズムは、精度や速度、解釈性、スケーラビリティなどの観点から使い分けられ、ビジネスや研究現場で幅広く活用されています。ここでは、実務でよく使われる10大アルゴリズムの中から代表的な5つを取り上げ、それぞれの特徴と活用シーンを詳しく解説します。

決定木(Decision Tree)の特徴と用途を解説

決定木は、データを分岐構造で分類していくアルゴリズムで、もっとも直感的かつ理解しやすい分析手法の一つです。各ノードで条件を分けながら、最終的に分類や予測を行う構造で、結果が木の形で可視化されるため、非エンジニアでも結果を把握しやすい点が大きなメリットです。また、説明力が高く、意思決定の根拠を明確に示すことができるため、業務への導入がスムーズです。ただし、単純な決定木は過学習しやすく、汎化性能が低くなる傾向があるため、枝刈り(pruning)やアンサンブル手法と組み合わせて使うのが一般的です。用途としては、顧客の解約予測、審査業務、診断支援などがあります。

ランダムフォレストとその高い予測精度の理由

ランダムフォレストは、複数の決定木を組み合わせて予測精度を高める「アンサンブル学習」の一種です。各決定木はランダムに選ばれたデータと特徴量を使って学習され、それらの予測結果を多数決や平均で統合することで、より堅牢で精度の高いモデルが構築されます。この手法はノイズに強く、過学習を防ぎやすいという利点があり、複雑なデータセットにも適用可能です。実際のビジネス現場では、顧客の購買予測、信用スコアリング、不正検出など、分類と回帰の両方で非常に高いパフォーマンスを発揮しています。アルゴリズムの仕組み自体は複雑でも、ライブラリの利用により簡便に実装できる点も人気の理由です。

サポートベクターマシン(SVM)の強みと限界

SVM(Support Vector Machine)は、データを「最も大きなマージン」で分割する境界線を見つけることで分類を行う手法です。特に、少量の高次元データに対して高い精度を示すため、画像認識やテキスト分類などで重宝されています。線形だけでなく、カーネル法を用いることで非線形な分離も可能となり、柔軟な対応力を持ちます。ただし、パラメータ調整やカーネル選定がモデル性能に大きく影響するため、専門的な知識や試行錯誤が必要になる点が難点です。また、大規模データへの対応や計算負荷の観点ではやや不利であるため、データ規模や目的に応じて他のアルゴリズムと使い分けることが求められます。

K-近傍法(KNN)による分類の仕組みとは

KNN(K-Nearest Neighbors)は、非常にシンプルな分類アルゴリズムで、新しいデータに対して近くの既知データ(K個)を参照し、多数決で分類を行う方法です。モデル構築の段階での学習が不要である「遅延学習型」であることから、予測時にすべての訓練データを保持しておく必要があります。そのため、データ量が多くなると処理時間が長くなり、パフォーマンスが低下するという課題があります。しかし、実装が容易で理解しやすいため、小規模データやシンプルな問題に適しており、教育現場やプロトタイピングなどで重宝されます。クラスタリングとの併用で分析精度を高めることも可能です。

クラスタリングにおけるK-means法の有用性

K-means法は、クラスタリングにおいて最もよく使われるアルゴリズムの一つで、データをあらかじめ設定したK個のグループに分類する手法です。初期のクラスタ中心をランダムに設定し、各データを最も近い中心に割り当て、クラスタの重心を再計算するという処理を繰り返します。K-meansは処理が高速で、大規模なデータにも対応できるという利点があり、顧客セグメンテーションや市場分析、画像処理など多くの分野で活用されています。ただし、初期値に結果が左右されたり、クラスタ数Kを事前に決めなければならないといった課題もあります。工夫次第で多様な応用が可能な非常に実用的な手法です。

AI・ビッグデータ時代の最新データマイニング動向とは

現代は、AIとビッグデータがビジネスと社会の基盤を形成する時代です。膨大なデータが日々生成されるなか、それを効果的に分析・活用する手段としてデータマイニングが進化を遂げています。特に、自然言語処理やディープラーニングといった先進技術との融合により、従来では困難だった非構造化データの解析も可能になり、多様な分野での応用が加速しています。さらに、リアルタイム処理のニーズの高まりや、クラウド基盤の整備も技術的進展を後押ししています。本章では、AI・ビッグデータとデータマイニングの最新の連携動向について、多角的な視点から詳しく紹介します。

ディープラーニングとの連携による高度分析の進化

ディープラーニングは、画像認識や音声解析、自然言語処理などで圧倒的な性能を誇るAI技術であり、データマイニングの枠を超えて多くの業界で採用されています。特に、ニューラルネットワークを多層構造にしたことで、従来の手法では捉えられなかった複雑なパターンを抽出することが可能になりました。これにより、マーケティングでは購買傾向の深層理解、製造業では異常検知の精度向上、医療分野では画像診断の自動化などが進展しています。一方で、解釈性が低いことや計算コストの高さといった課題もありますが、XAI(説明可能なAI)や軽量モデルの導入により、実務への適用が加速しています。

エッジコンピューティング時代の分散型分析手法

エッジコンピューティングとは、データをクラウドに送信することなく、現場のデバイス側(エッジ)で即座に処理を行う仕組みで、IoTの発展とともに注目を集めています。これにより、リアルタイム性が求められる現場でも遅延なく分析が可能となり、データマイニングの新たな活用領域が拡大しました。例えば、スマートファクトリーでは、生産機器から取得したセンサーデータを即時に解析し、不具合の兆候を検知してアラートを出すシステムが実装されています。クラウドへの依存を減らすことで、通信コストの削減やセキュリティ強化にもつながるため、分散型の分析基盤は今後さらに普及していくと見られます。

自然言語処理(NLP)とデータマイニングの融合

自然言語処理(NLP)は、文章や会話などの人間の言語データをコンピュータが理解・解析するための技術であり、テキストマイニングの基盤としても重要です。SNS投稿、商品レビュー、FAQ、顧客対応履歴など、膨大な非構造テキストデータをデータマイニングの枠組みで活用することが可能になります。たとえば、レビュー分析による商品改善や、カスタマーサポートにおける課題抽出、ブランド評価の推定など、活用事例は多岐にわたります。GPTのような大規模言語モデルと連携することで、より高精度なキーフレーズ抽出、感情分析、要約生成などが可能になり、実用性が大幅に向上しています。

ビッグデータ基盤とスケーラブルな処理技術の進化

ビッグデータを効率的に扱うには、処理速度・ストレージ容量・拡張性に優れたデータ基盤が必要です。HadoopやSparkといった分散処理フレームワークの発展により、大規模なデータセットを並列処理し、短時間で分析を完了させることが可能となりました。これらの基盤は、ストリーミング処理やバッチ処理の両方に対応し、企業はリアルタイムの意思決定や予測モデルの即時適用が可能になっています。また、クラウドプラットフォームではこれらの技術が統合されており、専門的な知識がなくても柔軟に運用できる環境が整っています。こうしたスケーラブルな技術の進化が、データマイニングの民主化と高速化を支えています。

オープンソースツールの普及と利用促進の動き

PythonやRをはじめとするオープンソース言語は、データマイニングにおいて欠かせない存在となっています。特に、scikit-learn、TensorFlow、XGBoost、LightGBMなどのライブラリ群は、無料でありながら高い性能と柔軟性を提供し、個人から企業レベルまで幅広く活用されています。また、可視化ツールとしてのTableau Publicや、ダッシュボード構築が可能なStreamlitなども登場し、非エンジニアでも扱いやすい環境が整備されています。GitHubやKaggleを通じたコミュニティの活性化により、ノウハウの共有や再利用が進み、技術の壁を越えた利用促進が広がっています。オープンソースの力が、データマイニングの裾野をさらに広げています。

循環型社会実現に向けたデータマイニング活用事例

循環型社会とは、資源の有効活用と廃棄物の削減を通じて持続可能な経済と環境を両立させる社会のことを指します。現在、多くの企業や自治体がこのビジョンに向けて動き出しており、データマイニング技術はその推進において重要な役割を担っています。製品のライフサイクル全体にわたるデータを収集・分析し、廃棄物の発生源やリサイクルの効率を明らかにすることで、資源循環の高度化が可能になります。ここでは、循環型社会を目指したデータマイニングの具体的な活用事例を紹介し、環境負荷低減への実効的アプローチを考察します。

資源リサイクルの最適化に向けたパターン分析事例

資源リサイクルの現場では、回収効率の向上とコスト削減を両立するために、データマイニングが積極的に活用されています。たとえば、自治体が実施している分別収集の履歴データや、市民の行動パターン、地域別の回収率データなどを分析することで、リサイクル率が高い地域と低い地域の違いを明確化し、効果的な啓発施策やルート改善に役立てられています。また、廃棄物の組成分析を通じて、資源化可能な物質の分布や頻度をモデル化し、再資源化施設の設計や稼働効率の向上に貢献する事例も見られます。こうした取り組みは、限りある資源の有効活用に直結し、循環型社会の基盤を支える重要な技術です。

廃棄物発生の予測と予防に活かすデータ分析手法

廃棄物の発生予測は、都市計画や廃棄物処理施設の運用にとって重要な課題です。データマイニングを活用することで、過去の排出量データ、季節変動、人口動態、経済活動との相関などを多角的に分析し、将来的な廃棄物量を高精度に予測することが可能になります。例えば、飲料メーカーでは、販売データと気温・イベントデータを掛け合わせることで、ペットボトル容器の回収量を事前に予測し、回収インフラの最適配置に成功したケースがあります。さらに、廃棄物の発生原因そのものを突き止め、製品設計や流通の段階で廃棄を抑えるような「予防型アプローチ」へと進化しつつあります。

省エネルギー化を実現するスマート管理の事例紹介

省エネルギーの分野でも、データマイニングは大きな役割を果たしています。特に、ビルや工場に設置されたセンサーから得られるエネルギー使用量の時系列データを分析することで、使用ピークの予測や異常消費の検出が可能になります。これにより、最適な空調・照明制御が実現されるだけでなく、不要な稼働の抑制による電力消費の削減が進みます。ある先進的なスマートビルでは、データマイニングにより入居者の行動パターンをモデル化し、自動でエネルギー最適化を行うシステムを導入しました。その結果、年間で20%以上の電力使用量を削減し、CO2排出量の大幅な抑制にも貢献しています。

環境モニタリングによる変化予測と対応の試み

大気汚染、水質、騒音、土壌汚染など、環境モニタリングの対象は多岐にわたりますが、これらの環境データをリアルタイムかつ高頻度で収集・分析することにより、突発的な変化や長期的な傾向を早期に捉えることが可能になります。データマイニングでは、気象データや地理情報と組み合わせた多変量解析によって、汚染拡大の予兆やリスクエリアの可視化が行われています。たとえば、河川の水質センサーから得られるpH値や濁度の変化パターンを分析し、異常発生前に警告を出すシステムが自治体で導入されている例もあります。このような早期警戒型の仕組みは、環境保護と住民の安全確保にとって極めて有効です。

サステナブルビジネスを支える意思決定支援事例

環境配慮型経営、いわゆるサステナブルビジネスの推進においても、データマイニングは企業の意思決定を支援する重要なツールとなっています。サプライチェーン全体のエネルギー使用量やCO2排出量を可視化し、改善余地のある工程を特定する分析が行われており、持続可能な調達方針やエコ設計の判断材料として活用されています。さらに、ESG投資においても企業の環境パフォーマンスを評価するためのエビデンスとして、データドリブンな評価が求められるようになっています。こうした意思決定支援の仕組みは、環境だけでなく企業価値の向上にもつながる好循環を生み出しています。